Quy Trình ETL Dữ Liệu: Cách Tối Ưu Hóa và Ứng Dụng Trong Xây Dựng Hệ Thống

Quy trình ETL (Extract, Transform, Load) đóng vai trò quan trọng trong việc xử lý và chuyển đổi dữ liệu trong hệ thống. Đây là một bước cơ bản trong việc xây dựng các hệ thống phân tích dữ liệu và kho dữ liệu (Data Warehouse), giúp các doanh nghiệp có thể tối ưu hóa việc thu thập và sử dụng dữ liệu. Trong bài viết này, chúng ta sẽ cùng tìm hiểu chi tiết về quy trình ETL, các bước trong quy trình này và vai trò của nó trong phân tích dữ liệu.

ETL Là Gì?

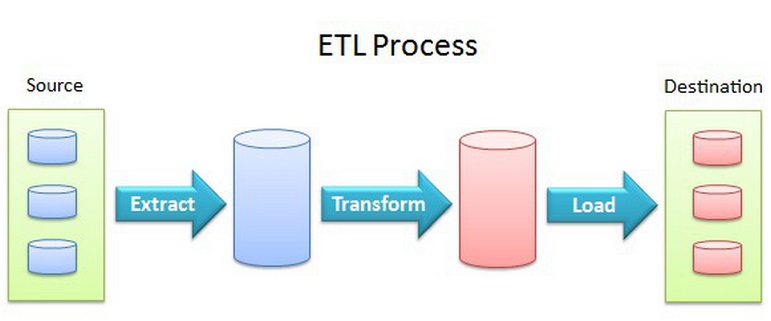

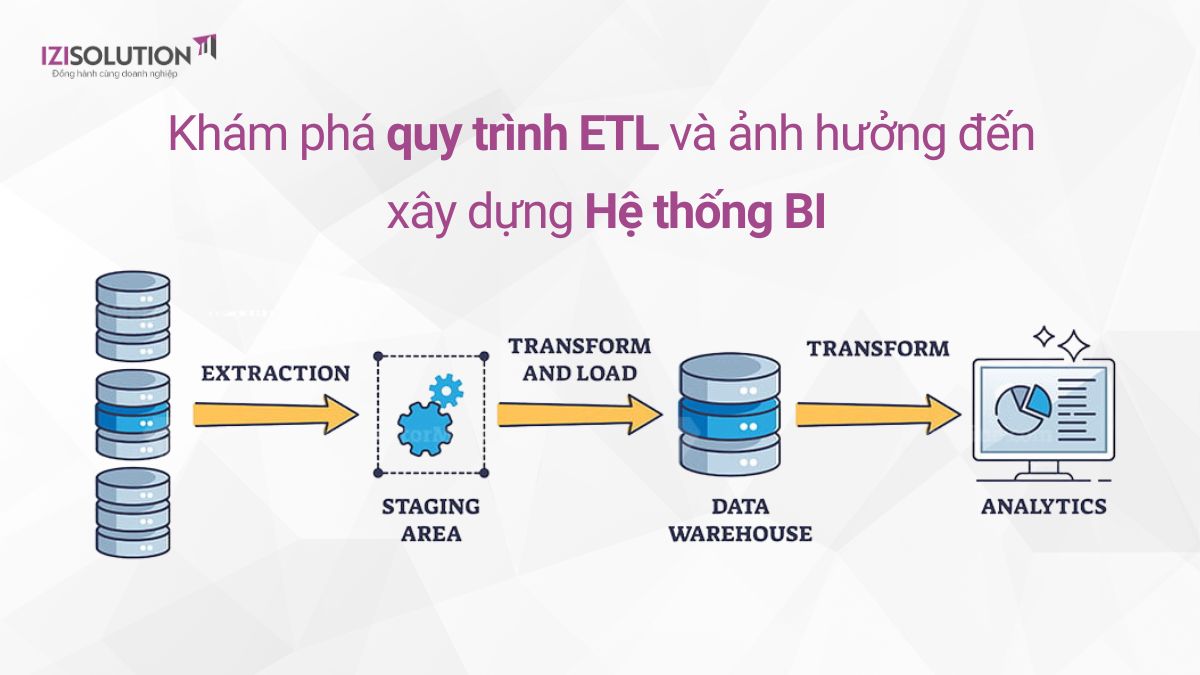

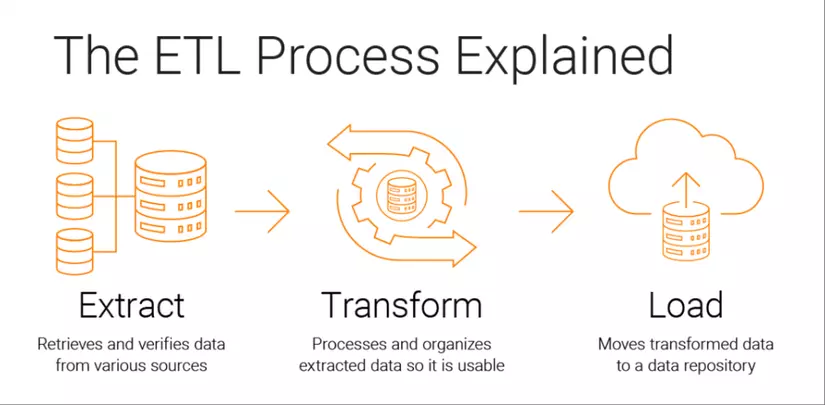

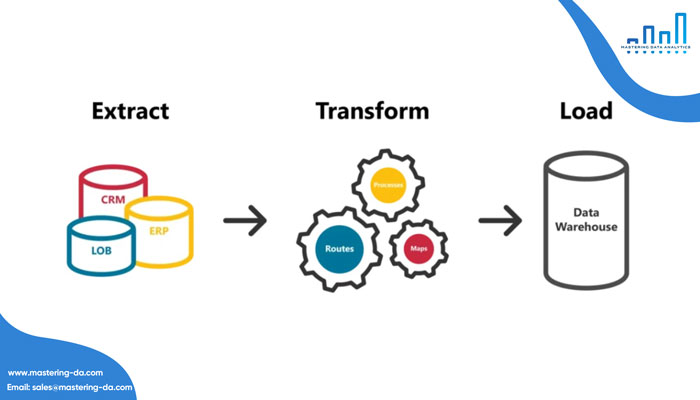

ETL là viết tắt của ba bước chính: Extract (Lấy dữ liệu), Transform (Chuyển đổi dữ liệu) và Load (Nạp dữ liệu). Mỗi bước trong quy trình này đều có vai trò quan trọng, giúp chuyển đổi dữ liệu từ các nguồn khác nhau thành thông tin có giá trị cho doanh nghiệp.

-

Extract (Lấy Dữ Liệu): Đây là bước đầu tiên trong quy trình ETL, nơi dữ liệu được lấy từ nhiều nguồn khác nhau như cơ sở dữ liệu, tệp tin, các hệ thống ngoài.

-

Transform (Chuyển Đổi Dữ Liệu): Sau khi dữ liệu được lấy, nó sẽ được chuyển đổi, làm sạch và định dạng lại sao cho phù hợp với hệ thống phân tích.

-

Load (Nạp Dữ Liệu): Cuối cùng, dữ liệu đã được chuyển đổi sẽ được nạp vào kho dữ liệu hoặc hệ thống phân tích để phục vụ cho mục đích sử dụng sau này.

Các Bước Trong Quy Trình ETL

1. Extract (Lấy Dữ Liệu)

Bước đầu tiên trong quy trình ETL là lấy dữ liệu từ nhiều nguồn khác nhau. Các nguồn này có thể bao gồm cơ sở dữ liệu quan hệ, dữ liệu từ API, tệp CSV hoặc thậm chí từ các hệ thống dữ liệu đám mây. Mục tiêu của bước này là thu thập tất cả dữ liệu cần thiết từ các hệ thống khác nhau để đưa vào quá trình tiếp theo.

-

Lấy dữ liệu từ cơ sở dữ liệu quan hệ: Các hệ thống như MySQL, SQL Server và Oracle là các nguồn dữ liệu phổ biến.

-

Lấy dữ liệu từ API: Đối với các dữ liệu từ các dịch vụ trực tuyến, API là cách phổ biến để trích xuất dữ liệu.

-

Lấy dữ liệu từ tệp tin: Các tệp như CSV, JSON và XML thường được sử dụng để lưu trữ dữ liệu.

2. Transform (Chuyển Đổi Dữ Liệu)

Bước chuyển đổi là một trong những bước quan trọng nhất trong quy trình ETL. Sau khi dữ liệu được trích xuất, chúng cần phải được chuyển đổi sao cho phù hợp với yêu cầu của hệ thống phân tích hoặc kho dữ liệu.

Các công việc trong bước chuyển đổi bao gồm:

-

Làm sạch dữ liệu: Loại bỏ các giá trị lỗi, các dữ liệu thiếu hoặc không hợp lệ.

-

Chuẩn hóa dữ liệu: Chuyển đổi dữ liệu thành định dạng chuẩn để có thể dễ dàng phân tích.

-

Tính toán các trường dữ liệu mới: Tạo ra các trường mới từ dữ liệu ban đầu như tổng hợp, tính toán tỷ lệ, hay phân loại dữ liệu.

Quá trình này có thể sử dụng các công cụ như Apache Spark, Talend, hoặc các giải pháp ETL tự động để xử lý dữ liệu.

3. Load (Nạp Dữ Liệu)

Bước cuối cùng trong quy trình ETL là nạp dữ liệu vào hệ thống đích, thường là kho dữ liệu (Data Warehouse). Dữ liệu sau khi được chuyển đổi sẽ được lưu trữ vào hệ thống lưu trữ vĩnh viễn để phục vụ cho các mục đích phân tích, báo cáo hoặc các hệ thống trí tuệ nhân tạo.

-

Nạp vào kho dữ liệu: Các kho dữ liệu như Amazon Redshift, Google BigQuery hay Microsoft Azure Synapse Analytics là những nơi thường xuyên tiếp nhận dữ liệu.

-

Nạp vào hệ thống phân tích dữ liệu: Các công cụ phân tích như Power BI, Tableau hay Looker có thể lấy dữ liệu từ kho dữ liệu để tạo báo cáo và trực quan hóa.

Tại Sao Quy Trình ETL Quan Trọng?

Quy trình ETL đóng vai trò cực kỳ quan trọng trong việc xây dựng hệ thống dữ liệu cho các công ty. Dưới đây là lý do tại sao ETL là bước không thể thiếu:

-

Tối ưu hóa dữ liệu: Quy trình ETL giúp xử lý, làm sạch và chuẩn hóa dữ liệu, đảm bảo rằng dữ liệu là chính xác và có thể sử dụng được.

-

Hỗ trợ phân tích dữ liệu: Sau khi dữ liệu được chuyển đổi, nó có thể dễ dàng sử dụng trong các hệ thống phân tích dữ liệu để đưa ra các quyết định kinh doanh.

-

Quản lý dữ liệu hiệu quả: ETL giúp quản lý và lưu trữ dữ liệu từ nhiều nguồn khác nhau, đảm bảo dữ liệu được tổ chức và dễ dàng truy xuất.

Công Cụ và Công Nghệ ETL Phổ Biến

Có rất nhiều công cụ và công nghệ hỗ trợ quy trình ETL. Một số công cụ phổ biến nhất bao gồm:

-

Apache Nifi: Một công cụ mã nguồn mở hỗ trợ xử lý và chuyển đổi dữ liệu.

-

Talend: Một nền tảng ETL mã nguồn mở giúp tích hợp dữ liệu từ các hệ thống khác nhau.

-

Microsoft SQL Server Integration Services (SSIS): Một công cụ mạnh mẽ từ Microsoft giúp thực hiện các tác vụ ETL trên cơ sở dữ liệu SQL Server.

-

Apache Airflow: Một công cụ mã nguồn mở giúp tự động hóa và lập lịch các công việc ETL.

FAQ Về Quy Trình ETL

1. ETL và ELT khác nhau như thế nào?

Trong khi ETL (Extract, Transform, Load) là quy trình dữ liệu được chuyển đổi trước khi nạp vào kho dữ liệu, ELT (Extract, Load, Transform) là quy trình mà dữ liệu được nạp vào kho dữ liệu trước, sau đó được chuyển đổi. ELT thường được sử dụng khi kho dữ liệu đủ mạnh để xử lý các thao tác chuyển đổi sau khi dữ liệu đã được nạp vào.

2. ETL có thể áp dụng cho các hệ thống dữ liệu lớn không?

Có, ETL là công cụ rất hiệu quả trong việc xử lý các dữ liệu lớn (Big Data). Các công cụ ETL hiện nay hỗ trợ xử lý hàng triệu bản ghi và có thể kết hợp với các công nghệ phân tán như Hadoop và Spark.

3. Quy trình ETL có thể được tự động hóa không?

Đúng vậy, quy trình ETL có thể được tự động hóa hoàn toàn bằng các công cụ như Apache Airflow hoặc Talend, giúp tiết kiệm thời gian và giảm thiểu sai sót trong quá trình xử lý dữ liệu.

Kết Luận

Quy trình ETL là một phần quan trọng trong việc xử lý và khai thác giá trị từ dữ liệu. Việc hiểu rõ quy trình này và áp dụng các công cụ phù hợp sẽ giúp doanh nghiệp tối ưu hóa việc quản lý và phân tích dữ liệu. Nếu bạn đang tìm kiếm cách thức tối ưu hóa dữ liệu trong công ty của mình, quy trình ETL chính là chìa khóa.